الگوریتمی که از طریق پاداش آموزش می بیند، نشان میدهد چگونه مغز ما نیز چنین عمل می کند

با بهینه سازی الگوریتم های reinforcement-learning (یادگیری تقویتی)، شرکت DeepMind جزئیات جدیدی درباره ی اینکه چگونه دوپامین به مغز در یادگیری کمک می کند، را کشف کرد.

با بهینه سازی الگوریتم های reinforcement-learning (یادگیری تقویتی)، شرکتDeepMind جزئیات جدیدی درباره ی اینکه چگونه دوپامین به مغز در یادگیری کمک می کند، را کشف کرد.

در مقاله ای که این روزها در Nature منتشر شده است،DeepMind ، شرکت تابعهیAlphabet’s AI ، از رویکردهایی از reinforcement-learning استفاده کرده است تا یک نظریه ی جدید درباره مکانیسم های پاداش در مغز را ارائه دهد. این فرضیه، با یافته های تجربی اولیه، نه تنها می تواند درک ما از سلامت روان و انگیزه را بهبود ببخشد، بلکه میتواند جهت فعلی تحقیقات هوش مصنوعی را برای ساختن هوشی عمومی شبیه انسان تعیین کند.

در سطوح بالا، reinforcement-learning بینش حاصل از «سگهای پاولف» را دنبال می کند: میتوان از یک مسالهی ساده تا مهارتهای جدید و پیچیده را از طریق فیدبک مثبت و منفی آموزش داد. یک الگوریتم با پیش بینی تصادفی اینکه کدام عمل می تواند برایش پاداش به ارمغان آورد یادگیری یک کار مشخص را آغاز می کند. سپس عمل را انجام می دهد، پاداش واقعی را مشاهده می کند و پیش بینی خود را بر اساس حاشیه ی خطا تنظیم میکند. طی بیش از میلیون ها یا حتی میلیاردها آزمایش، خطاهای پیش بینی الگوریتم به صفر همگرا می شوند، مرحله ای که الگوریتم می داند دقیقاً برای انجام حداکثر پاداش خود چه اقداماتی را انجام دهد و بنابراین وظیفه خود را انجام می دهد.

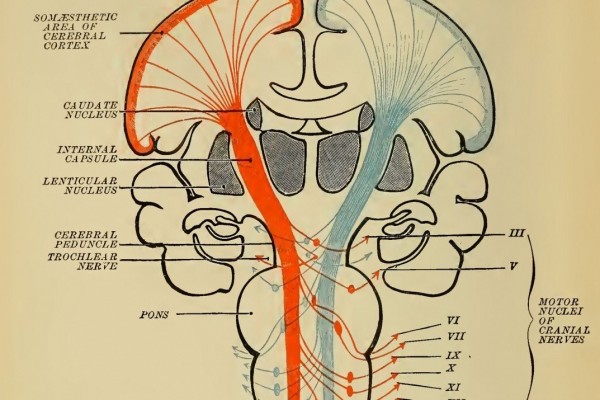

این امر مشخص ساخت که سیستم پاداش مغز نیز به همین روش عمل می کند – کشفی در دهه 1990 ، با الهام از الگوریتم های reinforcement-learning . هنگامی که یک انسان یا حیوان در حال انجام عملی است، نورون های دوپامین آن در مورد پاداش مورد انتظار پیش بینی می کنند. پس از دریافت پاداش واقعی، آنها مقدار دوپامین را که منطبق با خطای پیش بینی است، آزاد میکنند. پاداش بهتر از حد انتظار باعث آزاد شدن دوپامین میشود، در حالی که پاداش کمتر از حد انتظار تولید مواد شیمیایی را متوقف می کند. به عبارت دیگر، دوپامین به عنوان یک سیگنال تصحیح عمل می کند و به نورون ها می گوید پیش بینیهای خود را تا زمانی که به واقعیت نزدیک شوند، تنظیم کنند. این پدیده، معروف به خطای پیش بینی پاداش، بسیار شبیه به یک الگوریتم reinforcement-learning است.

مقاله جدید DeepMind بر ارتباط تنگاتنگ بین این مکانیسم های یادگیری طبیعی و مصنوعی بنا شده است. در سال 2017 ، محققان این شرکت، الگوریتم reinforcement-learning را معرفی کردند که از آن زمان عملکرد فزاینده ای را در کارهای مختلف در دسترس قرار داده است. آنها اکنون بر این باورند که این روش جدید می تواند توضیحی دقیقتر در مورد چگونگی عملکرد نورون های دوپامین در مغز ارائه دهد.

به طور خاص، این الگوریتم بهبود یافته نحوه ی پیش بینی پاداش را تغییر می دهد. در حالی که رویکرد قدیمی، پاداشها را به عنوان یک تعداد واحد تخمین می زد - به معنای مساوی بودن با نتیجه مورد انتظار - رویکرد جدید آنها را با دقت بیشتری به عنوان یک توزیع بیان می دارد. (لحظه ای در مورد یک دستگاه شانسی فکر کنید: می توانید با توزیعی مشخص، برنده یا بازنده شوید. اما به هیچ وجه نتیجه مورد انتظار متوسط را دریافت نخواهید کرد.)

اصلاحات انجام شده خود را به فرضیه جدیدی سوق میدهد: آیا نورونهای دوپامین نیز با همان روش توزیع، پاداش را پیش بینی می-کنند؟

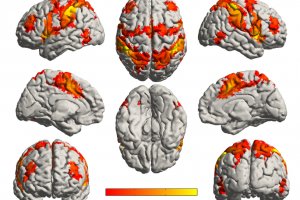

برای آزمایش این تئوری، آنها برای موشها وظیفهای تعیین کردند و بر اساس پیشامد تاس، به آنها پاداش دادند و الگوهای شلیک نورونهای دوپامین را اندازه گیری کردند و دریافتند که هر نورون مقدار متفاوتی از دوپامین آزاد می کند، به این معنی که نتایج متفاوتی را پیش بینی کردند. برخی، پاداش ها را بالاتر از آنچه در واقعیت دریافت می کردند، پیش بینی می کنند و برخی دیگر تخمینی کمتر از واقعیت می زدند. زمانیکه محققان تعیین توزیع آن پیش بینی ها را در مورد بررسی قرار دادند، این توزیع تقریبا توزیع پاداش های واقعی را دنبال می کرد. این داده ها شواهد قانع کننده ای را ارائه می دهند مبنی بر اینکه مغز در واقع از توزیع پیش بینی های پاداش برای تقویت الگوریتم یادگیری خود استفاده می کند.

با رمزگشایی بیشتر فرآیندهای مغز، نتایج همچنین روشن می کند که چه چیزی باعث ایجاد هوش انسانی می شود. این امر درک جدیدی را به ما در مورد آنچه در مغز ما طی زندگی روزانه اتفاق میافتد می دهد.

منبع: technologyreview

نوشته های مرتبط